音乐是人们情感、认知和社交生活的核心部分。在过去的几十年里,人们在理解音乐感知的神经基础方面取得了巨大的进步,有多项研究评估了音色、音高、旋律、和声和节奏等孤立的音乐元素的神经相关性。然而,基于音乐感知的精确神经动力学仍然未知。2023年8月15日,加州大学伯克利分校的Ludovic Bellier博士后和Robert T. Knight教授及其研究团队在PLOS Biology(IF=9.8)上发表了题为“Music can be reconstructed from human auditory cortex activity using nonlinear decoding models”的文章,研究人员通过对29 名患者的独特颅内脑电图(iEEG)的编码和解码分析,发现大脑的右半球主导音乐感知,颞上回(STG)起主要作用。此研究还表明,在单个患者获得的短数据集上应用预测建模是可行的,这为在脑机接口(BCI)应用中添加音乐元素提供了新思路。“All in All it was just a brick in The wall”这句话在重新编排的歌曲中清晰地出现了:节奏准确,虽然歌词含糊不清,但却清晰可辨。这是研究人员第一次从大脑录音中重建出可识别的歌曲,显示了记录和翻译脑电波以捕捉语音的音乐元素以及音节的可行性。这些被称为韵律的音乐元素——节奏、重音、重音和语调承载着单词本身无法传达的含义。“这是一个奇妙的结果,”神经学家、加州大学伯克利分校心理学教授Robert Knight说,“随着整个脑机接口领域的发展,音乐的韵律和情感内容提供了一种方法:将音乐性添加到未来的大脑植入物中,不仅可以解码语言内容,还能解码语言的韵律内容和情感。我认为这是我们真正开始破解密码的地方。”这项新研究重新分析了2012年和2013年获得的大脑录音并超越以往的研究,即测试解码模型是否可以识别不同的音乐作品和流派,通过基于回归的解码模型来真正重建音乐短语。

解码分析

解码分析

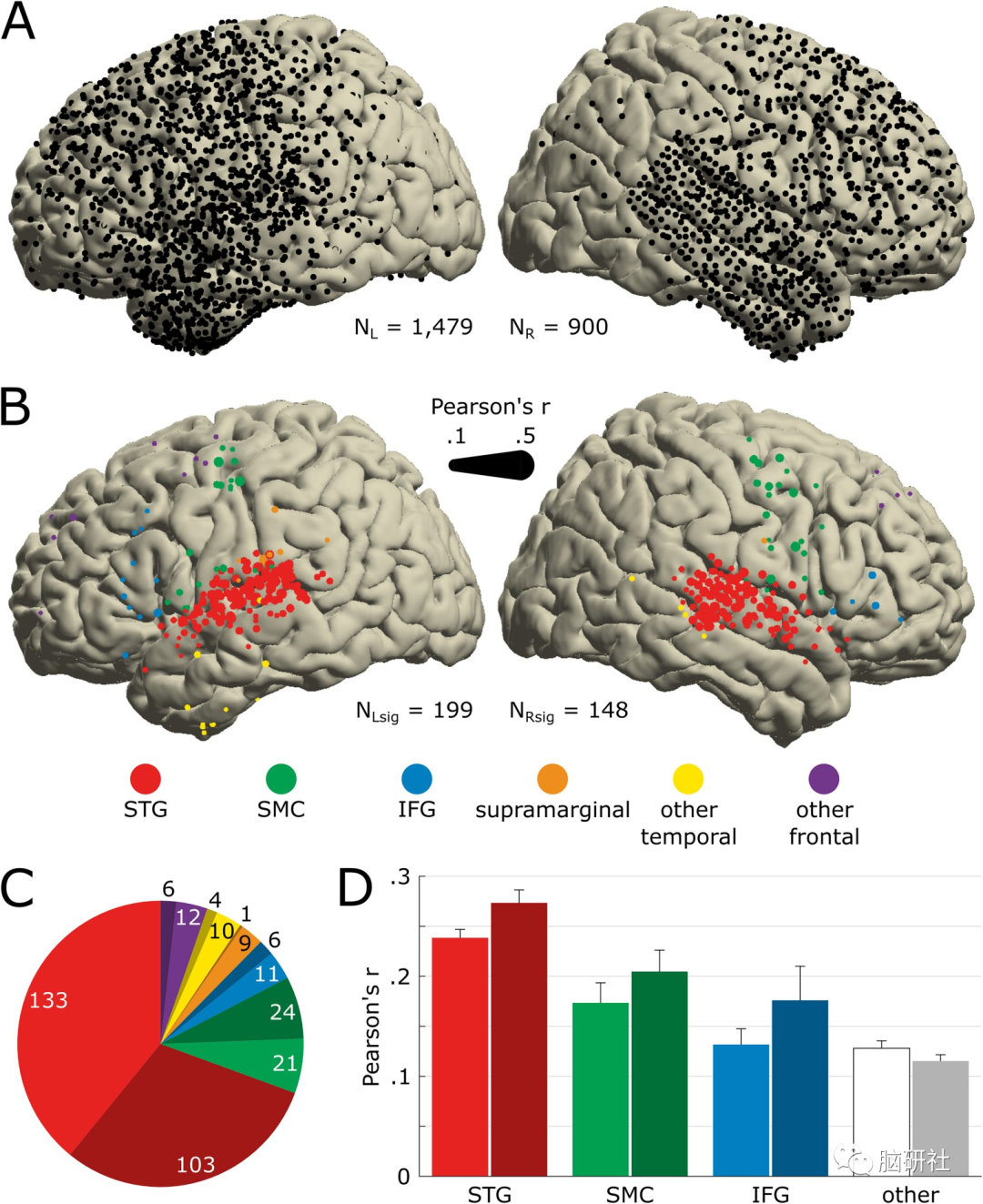

研究人员发现,347个显著电极中的大多数(87%)集中在 3 个区域:68%在双侧颞上回(STG), 14.4%在双侧感觉运动皮层(SMCs,位于中央前和后回),4.6%在双侧 IFG。研究人员还证实,右脑比左脑更能适应处理音乐方面的信息。

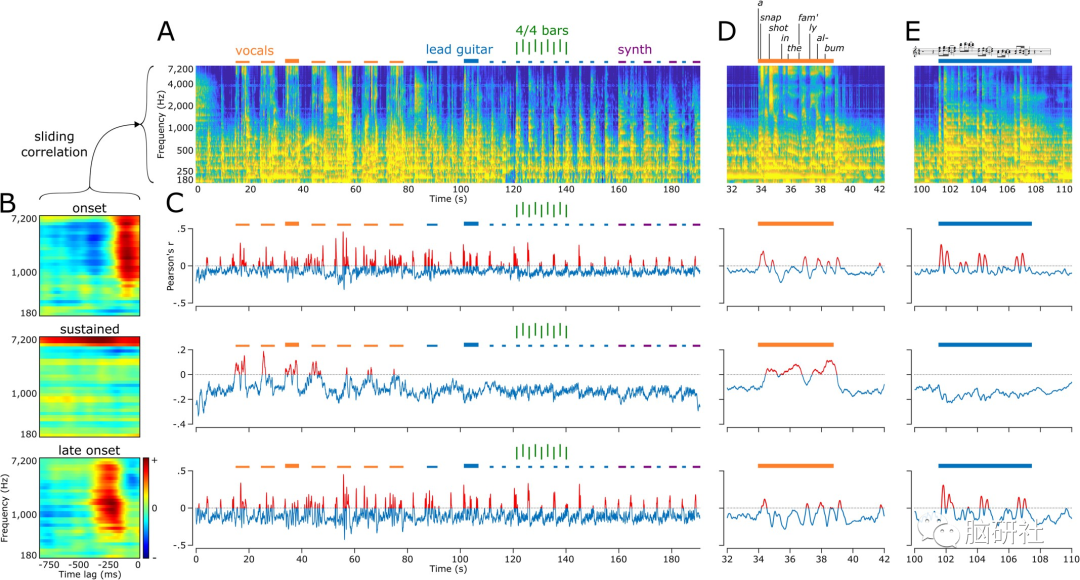

研究人员强调,这项研究使用人工智能来解码大脑活动,再进行编码。他们还能够精确定位大脑中参与检测节奏的新区域,例如弹奏的吉他,并发现听觉皮层的某些部分——位于耳朵后面和上方的颞上回在声音或合成器开始时做出反应,而其他区域则对持续的人声做出反应。此外,研究人员表示他们将会开展一项新的研究,以了解大脑回路,这些回路允许一些因中风或脑损伤而失语的人在找不到表达自己的单词时可以通过唱歌进行交流。

Robert T. Knight

参考文献

Bellier L, Llorens A, Marciano D, Gunduz A, Schalk G, Brunner P, Knight RT. Music can be reconstructed from human auditory cortex activity using nonlinear decoding models. PLoS Biol. 2023 Aug 15;21(8):e3002176. doi: 10.1371/journal.pbio.3002176. PMID: 37582062; PMCID: PMC10427021.

资讯来源

https://www.sciencedaily.com/releases/2023/08/230815151112.htm

所有注明出处的文章,旨在分享、传播,如有侵权,请及时联系我们,我们将尽快处理

解码分析